Mit der Vorstellung der neuen NVIDIA GeForce RTX Reihe sind sie aktuell wieder überall im Gespräch: Grafikkarten. Doch was kann man sich eigentlich darunter vorstellen? Was steckt hinter den schicken Gehäusen und blinkenden LED-Lüftern? Was sind Shader und wie funktioniert Raytracing? In unserer neuen Artikel-Reihe Computer erklärt! wollen wir euch diese Fragen beantworten.

Was ist eine Grafikkarte?

Computer sind heute allgegenwärtig. Doch für viele ist ein PC einfach nur ein Gerät mit Bildschirm, Maus und Tastatur. Damit ein Computer so funktioniert wie wir es heute kennen, ist das Zusammenspiel vieler Komponenten notwendig. Die Grafikkarte übernimmt dabei eine elementare Aufgabe: Die visuelle Darstellung von digitalen Inhalten.

Das allein würde der Aufgabenbeschreibung moderner Grafikkarten jedoch bei weitem nicht gerecht werden, denn sie leisten noch viel mehr. Insbesondere im Bereich Gaming wird von einer Grafikkarte alles gefordert. Dazu gehören physikalische Berechnungen wie Schwerkraft, Reflektion von Licht, Schatten aber auch Sourround-Sound Berechnung in Spielen. Außerdem kommen Performance Optimierungen oder professionelle Features für industrielle Zwecke, insbesondere im Bereich der Parallelisierung, also der zeitgleichen Berechnung vieler verschiedener Dinge, hinzu.

Wie funktioniert eine Grafikkarte?

Um das zu verstehen, ist es zunächst interessant zu wissen, was um die Grafikkarte herum passiert. Das einfachste ist dabei das Bild, welches wir schlussendlich auf dem Bildschirm sehen werden, egal ob es ein Video, Foto, eine Website oder ein Spiel ist. Jeder hat heute schon mal das Wort "Pixel" gehört. Ein Bild besteht typischerweise aus einer sehr hohen Anzahl an Pixeln. Ein Pixel ist dabei ein Bildpunkt, also genau ein Farbwert. Ähnlich wie bei einem Mosaik ergeben viele dieser Bildpunkte zusammen ein für den Menschen identifizierbares Bild.

Pixel und Auflösungen

Ein Bild in Form von einer Menge an Pixeln ist also das, was uns die Grafikkarte schlussendlich liefern muss. Generell gilt: Je größer die Menge an Pixeln, also die Auflösung des Bildes, desto mehr Leistung wird benötigt. Als Auflösung bezeichnet man eine Zusammensetzung von Pixeln, mit einer Anzahl Pixel in der Länge und der Höhe des Bildes.

Berechnung von Fotos

Nun muss eine Grafikkarte natürlich erst einmal wissen, was für ein Bild sie anzeigen soll. Bei einem Foto ist das zum Beispiel sehr einfach: Das Foto selbst ist schon eine Menge an Pixeln, die Grafikkarte muss also üblicherweise nichts weiter tun als die Daten vom Foto zu lesen, meist aus einem bestimmten (Daten-)Format in ein anderes umwandeln, und dies anschließend an den Bildschirm weiter geben. Ein Datenformat kann man sich wie gefaltetes Papier vorstellen: Es gibt verschiedene Möglichkeiten, und manche eignen sich besser und manche schlechter um das Papier aufzubewahren. Die Schwierigkeit dieser Aufgabe fällt bei einer modernen Grafikkarte in die Kategorie "sehr leicht".

Berechnung von Websites: Text und Videos

Ähnlich leicht sind zum Beispiel Websites: Zusätzlich zu Bildern kommen hier noch Text und Videos. Die visuelle Berechnung von Text ist abstrakt gesehen auch sehr einfach: Buchstaben, Zahlen und Symbole lassen sich wunderbar abspeichern und übertragen. Um Text darzustellen braucht man dann nur noch ein Schriftpaket. Dies enthält (vereinfacht gesagt) für jeden Buchstaben ein Bild. Die Grafikkarte muss also letztendlich nur eine Menge an kleinen Bildern berechnen. Keine Herausforderung also. Auch Videos sind nicht kompliziert: Im Grunde besteht ein Video ja nur aus ganz vielen zusammengesetzten Fotos. Hier ist jedoch die Auflösung des Videos schneller relevant als bei einem Foto, denn die Datenmenge je Sekunde, die die Grafikkarte verarbeiten muss, nimmt natürlich sehr schnell zu. Schwache Grafikkarten können deswegen hochauflösende Videos nicht immer flüssig verarbeiten.

Berechnung von Spielen

Kommen wir zu den spannenden Aufgaben einer im Consumer-Bereich üblichen Grafikkarte: Gaming. Hier werden die Unterschiede zwischen einfachen und teuren Grafikkarten besonders deutlich. Die folgende Erklärung ist stark abstrahiert und in einzelne Schritte unterteilt, die in echt nicht zwingend in dieser Reihenfolge ablaufen müssen. So wird es jedoch leichter verständlich 😉

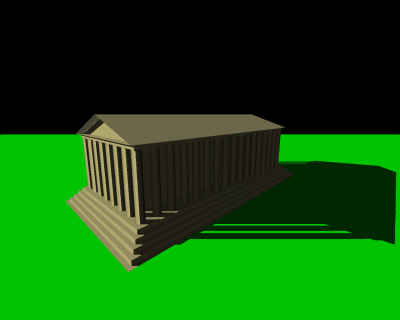

Starten wir mit den Daten, die aus einem Spiel stammen und an die Grafikkarte weitergegeben werden. Üblicherweise sind das Polygone, also mathematische Objekte die aus einer Menge an Vektoren bestehen. Ein Polygon beschreibt damit zunächst einmal alle (genauer: die wichtigsten) Kanten eines Objekts. Folgendes Bild zeigt ein Raumschiff als Beispiel. Allerdings sind auf dieser Grafik auch schon Schatten sichtbar, die existieren in dem Datensatz des Polygons natürlich nicht.

Was muss alles passieren, um aus einem Haufen Vektoren ein Raumschiff auf dem Display zu sehen, dessen Hüllenlackierung das Sonnenlicht einer imaginären Galaxie reflektiert?

Polygone, 3d und 2d

Als Ausgangsdaten existieren zunächst die schon erwähnten Polygone. Diese repräsentieren ein dreidimensionales Objekt. Die erste Herausforderung ist es also, dieses dreidimensionale Objekt auf einem zweidimensionalen Bildschirm darzustellen. Dieser Vorgang ist wichtigster Bestandteil im sogenannten "Rendering". Um ein 2d Bild aus dem 3d Objekt zu erzeugen, muss eine "Kameraperspektive" existieren, also ein Punkt, von dem aus das Objekt betrachtet werden soll. Wenn wir als Mensch vor einem Haus stehen, sehen wir ja auch nur die Vorderseite, und nicht gleichzeitig die Rückseite. Genau das wird in diesem Schritt vollbracht. Anhand der Perspektive wird entschieden, wie aus dem Polygon ein 2d Bild erzeugt wird. Hierbei geht offensichtlich Information verloren, nämlich alles was nicht im sichtbaren Bereich der "Kamera" ist. Das erzeugte 2d-Bild ist sozusagen eine Projektion des Polygons und hat schon hier eine festgelegte Auflösung (die noch nicht unbedingt mit der des Bildschirms übereinstimmen muss).

Kantenglättung

Nun haben wir ein Polygon auf eine ebene Fläche projiziert. Dabei kommt man ganz schnell auf ein Problem: Kantenglättung. Ein Bildschirm hat üblicherweise quadratisch angeordnete Pixel, also ein gleichmäßiges Raster. Horizontale und vertikale Linien lassen sich darauf wunderbar klar abbilden, doch alles andere wirkt ohne Nachhilfe sehr unnatürlich. Am einfachsten lässt sich Kantenglättung bei Schriften erklären, mithilfe eines Bildes.

Die obere Zeile Schrift sieht im Vergleich zur unteren sehr unnatürlich aus, und kein Mensch würde so eine Schrift lange lesen können ohne Kopfweh zu bekommen. Das Ziel von Kantenglättung ist also, Kanten natürlicher, weicher aussehen zu lassen. Ausgehend von den ursprünglichen Kanten aus dem projizierten Polygon, wird nun also auf Pixelebene Kantenglättung, auch Antialising genannt, durchgeführt. Dafür gibt es inzwischen unzählige Technologien, die ihr in einigen Spielen unter Namen wie MXAA, FXAA, SSAA, usw. finden könnt. Diese unterscheiden sich letztendlich in Qualität und benötigter Leistung.

Vereinfacht gesagt werden in allen Verfahren Durchschnittswerte mit den benachbarten Pixeln gebildet. Die besten Ergebnisse werden durch einen einfachen, aber leistungshungrigen Ansatz erzielt: Down- bzw. Supersampling. Die Projektion wird also auf einer höheren Auflösung durchgeführt, wie sie schlussendlich der Monitor besitzt. Dann gibt es Mischformen wie MSAA, die immer noch gute Ergebnisse erzielen, aber durch ein paar Tricks die benötigte Leistung spürbar reduzieren. Zu den einfacheren aber effizienten Varianten gehört zum Beispiel FXAA. Am besten spielt ihr mal mit einigen dieser Optionen herum, um das Ergebnis zu erzielen, das euren Ansprüchen am ehesten gerecht wird.

Texturen

Okay, jetzt haben wir ein natürlich aussehendes, projiziertes Polygon. Das ist aber immer noch kein schönes Raumschiff. Eine elementare Aufgabe einer Grafikkarte ist also die Verknüpfung der Objekte mit Texturen. Texturen sind im Grunde einfach nur Bilddateien. Oft jedoch mit einigen Besonderheiten.

Texturen existieren in verschiedener Qualität, also eigentlich immer in verschiedener Auflösung. Je höher ihr in einem Spiel die Grafikqualität stellt, desto höher ist meistens die Auflösung der verwendeten Texturen. Folgende Grafik zeigt den Einfluss von Texturen auf ein Spiel sehr deutlich: Rechts die originale vs. Links eine hochauflösendere (und etwas anders gefärbte) Textur. Die Linke wirkt dank der höheren Auflösung deutlich weicher und natürlicher.

Texturen haben oft noch eine weitere Besonderheit: Sie können beliebig oft nebeneinander angewendet werden. Dadurch ist es möglich, beliebig große Flächen mit einer kleinen Textur-Datei zu füllen, ohne dass Kanten wie bei einem Fliesenboden entstehen. Grafikkarten bieten darüber hinaus verschiedene Features, Texturen miteinander zu kombinieren um aus einer möglichst kleinen Ausgangsmenge an Daten ein möglichst natürliches, abwechslungsreiches Bild zu erzeugen.

Hochauflösende Texturen sind übrigens mit der größte Speicherfresser in einer Grafikkarte. Das heißt - je höher eure Spielqualität oder die Auflösung des Bildschirms, desto mehr Grafikspeicher braucht eure Karte, damit das Spiel flüssig läuft.

Shader

Inzwischen haben wir ein 3d Objekt zweidimensional abgebildet, inklusive Kantenglättung und Textur. Damit sähe ein Bild aber immer noch unglaublich unnatürlich aus. Um das zu ändern, gibt es Shader. Diese sind heutzutage ziemlich mächtig. Sie sind dafür verantwortlich, dass manche Texturen Licht spiegeln, rau oder glatt aussehen, sich bewegen (Wasseranimation) und vieles mehr. Shader müssen von Spiele-Entwicklern programmiert werden. Um das zu vereinfachen, gibt es einige Standards. Bekannte Namen sind DirectX und OpenGL, aber auch die recht junge Vulkan Engine von AMD. DirectX findet ihr offiziell nur auf Windows, während OpenGL auf allen Plattformen funktioniert.

Wie genau funktioniert ein Shader? Das ursprüngliche Polygon mit inzwischen platzierten Texturen besteht aus vielen Vektoren. Bei der Kantenglättung waren die Kanten dabei wichtig, jetzt geht es um die Flächen zwischen den Kanten. Mathematisch gesehen ist eine Fläche ja eine Ebene, also umgangssprachlich "glatt". Bis auf vielleicht bei Fensterscheiben findet man das in der realen Welt wohl nie. Ein Shader kann also Oberflächenstrukturen beeinflussen, oder sogar das "Gitter" des Polygons manipulieren, also in der Regel erweitern. Außerdem können die Texturen um "Height-Maps" oder "Displacement-Maps" erweitert werden. Diese werden von der Grafikkarte als Höhe oder Verzerrung interpretiert. Sichtbar wird das ganze, sobald Licht gebrochen wird oder Schatten geworfen werden.

Auf dem Bild sieht man eine Textur und eine zugehörige Height-Map. Bei dieser gilt: Je dunkler ein Pixel, desto "tiefer" sieht die Stelle später auf der Textur aus, was beispielsweise durch Schatten spürbar wird. Andere Maps können zum Beispiel Informationen enthalten, welcher Pixel der Textur wie stark Licht spiegeln soll, andere, "was" gespiegelt wird (sofern nicht echte umgebende Objekte gespiegelt werden).

Achtung, Verwechslungsgefahr: Die Rechenkerne einer Grafikkarte werden manchmal auch als Shader bezeichnet, da sie für all diese Berechnungen verantwortlich sind!

Licht und Schatten

Beide Begriffe sind schon das ein oder andere Mal aufgetaucht, und beide sind essentiell für ein natürliches Bild notwendig: Licht und Schatten. Gehen wir zurück zu unserem 3d Polygon, das in einem Raum existiert. Neben vielleicht anderen 3d und 2d Objekten und einem Hintergrund (wie in einem TV-Studio...) gibt es außerdem Lichtquellen. Die Grafikkarte kann anhand der Lichtquellen Helligkeiten, Reflektionen und eben Schatten berechnen. Nicht in jedem Spiel wird dies exzessiv eingesetzt, da auch hier eine Menge Rechenaufwand drin steckt.

Beispielsweise in älteren Strategie-Spielen, die durch eine klassische Draufsicht charakterisiert werden, werden Ressourcen sparende Shadow-Maps erzielt. Es gibt sozusagen nur eine Lichtquelle (sozusagen eine Sonne) und alle Schatten können mehr oder weniger statisch direkt aus einem Umriss des 3d Objekts generiert werden. Solche Lichter mit parallelen Strahlen werden auch Umgebungslicht genannt, Schatten sind nur abhängig vom Winkel des einfallenden Lichts.

In 3d Spielen wie Minecraft oder diversen Shootern dagegen haben Licht, Dunkelheit und Schatten einen zentralen Einfluss auf das Spielgeschehen. So ist beispielsweise in Minecraft jede Fackel eine Lichtquelle, die die Umgebung in einem bestimmten Radius beeinflusst. Diese Lichter nennt man Punktlichter, da sich der Schatten mit dem Winkel und dem Abstand/Position des Lichts ändert.

Generell gilt: Je mehr Objekte und je mehr Lichtquellen, desto mehr Rechenaufwand für die Grafikkarte. In einigen Engines gilt deshalb auch, dass ohne Licht der Rechenaufwand quasi gleich Null ist. Ein schwarzer Bildschirm mit 1000fps bringt ja auch niemandem was 😉

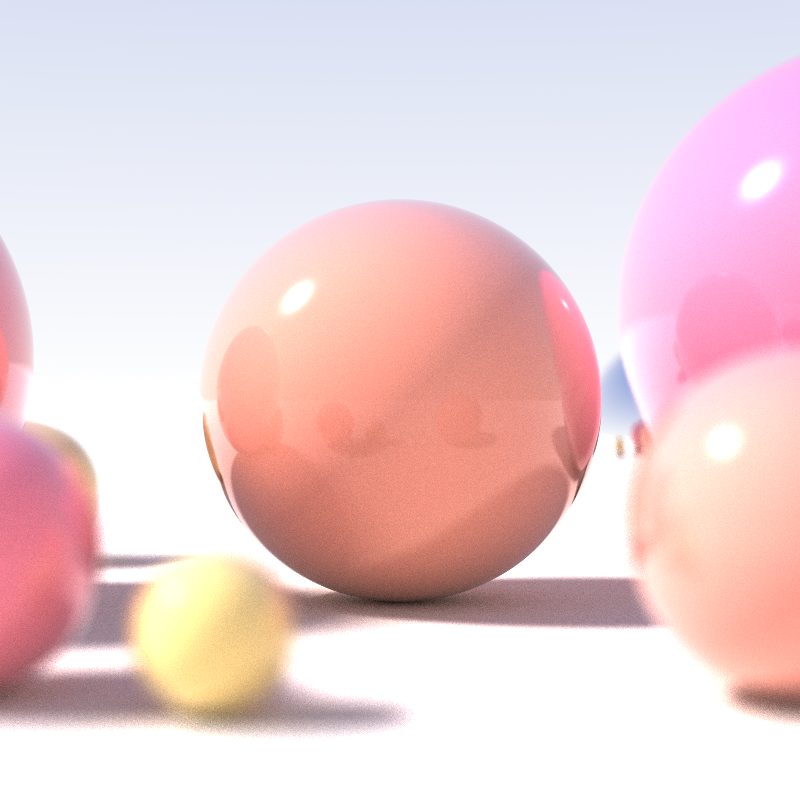

Raytracing

Der Begriff ist den meisten wohl nur im Zusammenhang mit den neusten Nvidia RTX Grafikkarten zu Ohren gekommen. Dabei ist die Idee des Raytracings schon viele Jahre alt und wurde in der Filmindustrie im Bereich Animation schon häufig eingesetzt, um fotorealistische Animationen zu erstellen. Das besondere bei den neusten Grafikkarten ist im Prinzip "nur", dass diese genügend Leistung bieten, Raytracing in Echtzeit für Spiele zu berechnen.

Doch was steckt hinter Raytracing? Im Grunde handelt es sich um eine Möglichkeit der Verdeckungsberechnung. Die vorher genannten Methoden zur Berechnung von Schatten oder Licht versuchen alle, mithilfe von Tricks die Realität zu simulieren. Raytracing kann das so ziemlich ohne Tricks: Nach Vorbild des in der Physik anerkannten Modells der geometrischen Optik ist Licht in dieser Berechnung eine Menge von Strahlen. Verschiedene Materialien haben unterschiedlichen Einfluss darauf, wie die Lichtstrahlen reflektiert, gebrochen oder verschluckt werden. Damit lassen sich unglaublich realistische Szenen am Computer erstellen.

Und vieles mehr...

Die bisher genannten Methoden gehören nur zu den grundlegendsten und wurden stark vereinfacht beschrieben. Wenn man sich überlegt, dass das alles in nahezu Echtzeit für wahnsinnig komplexe Szenen berechnet wird, kann man eigentlich nur staunen.

Weitere Aufgabengebiete für Grafikkarten

Im industriellen Bereich gibt es noch viele weitere Gebiete, in denen Grafikkarten ihre Daseinsberechtigung ausleben. Dazu gehört natürlich 3d Modelling und Design. Hierfür gibt es spezielle Grafikkarten, die beispielsweise in Dingen wie Shader-Berechnungen deutliche schwächer sind als aktuelle Gaming Grafikkarten, dafür aber auch mal 32 GB Grafikspeicher haben, um Auflösungen im 8k oder 10k Bereich zu bedienen.

Ein weiteres Einsatzgebiet finden Grafikkarten im Bereich Mining und KI. Ersteres ist vor allem bekannt durch Bitcoin und andere Kryptowährungen. "Mining" ist im wesentlichen "ausprobieren", also Zufälle zu generieren und zu testen. Die Fähigkeit von Grafikkarten, unglaublich viele Dinge gleichzeitig zu berechnen kommt da sehr gelegen. Das ist auch der Hauptgrund für den Einsatz in KI-Szenarien. Auch hier geht es darum, möglichst schnell sehr große Datensätze zu lesen und zu interpretieren.

Grafikkarten - Markt: Worauf muss ich achten?

Nun haben wir gelernt, was denn grob in jeder Grafikkarte abläuft, wenn sie in einen Computer eingebaut ist. Was in der Praxis natürlich mehr Relevanz hat: Dass es für die eigenen Zwecke ausreichend funktioniert und man die richtige Grafikkarte besitzt. Dabei gibt es einige Merkmale, die euch helfen können eure nächste Grafikkarte auszuwählen.

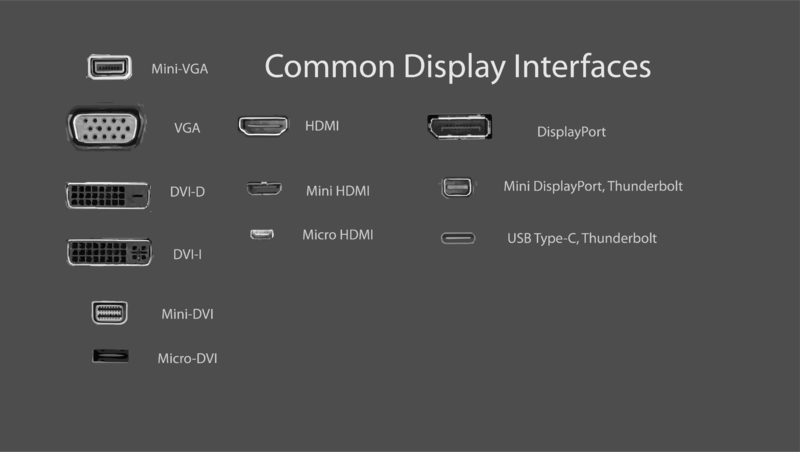

Anschlüsse

Inzwischen ist das tatsächlich nicht mehr so relevant wie noch vor ein paar Jahren, da die meisten Anschlüsse inzwischen überall verfügbar sind. Um sicher zu gehen, vergleicht einfach die Eingänge eures eventuell schon vorhandenen Monitors mit den Ausgängen der Grafikkarte. Aufpassen müsst ihr, wenn euer Monitor eine höhere Auflösung als fullHD hat: Dann werden die Generationen der verschiedenen Anschlüsse relevant, da z.B. HDMI und DisplayPort erst ab einer gewissen Generation höhere Auflösungen und / oder höhere Bildfrequenzen als 60Hz unterstützen.

Generation

Das Alter einer Grafikkarte ist ebenfalls entscheidend für einige Faktoren: Zum Beispiel OpenGL bzw. DirectX Versionen. Ältere Modelle sind meist nicht mit den neusten Engines kompatibel, sodass ihr weniger aus einem Spiel raus holen könnt, als dies vielleicht in der Theorie unterstützt, obwohl die effektive Leistung der Grafikkarte noch reicht. In jeder Spezifikation einer Grafikkarte steht jedoch die neuste unterstützte Version drin, ebenso in den Spielen, welche Version für das beste Resultat gebraucht wird.

Rechenkerne

Die Anzahl der Rechenkerne (Cores) sind zumindest innerhalb einer Marke ein ziemlich eindeutiges Zeichen, wie viel Leistung eine Karte bringt. Mehr Kerne = mehr Leistung. Die Kerne sind nachher für die letztendliche Berechnung aller Effekte und der Gesamtausgabe zuständig.

Grafikspeicher

Der Grafikspeicher (auch VRAM) ist in den letzten Jahren von Generation zu Generation signifikant gestiegen. Er wird vor allem für Gaming mit hoher Auflösung und/oder hochauflösenden Texturen benötigt. Beim Grafikspeicher ist auch dessen Alter interessant: Neue Standards wie GDDR6 erlauben unglaublich hohe Schreib-/ und Lesegeschwindigkeiten, die den Vorteil gegenüber älteren Generationen noch weiter steigern.

Kühlung

Die Grafikkarte ist in den meisten PCs der hungrigste Stromfresser. Das heißt auch: sie produziert am meisten Abwärme. Heutige Grafikkarten gibt es mit unterschiedlichsten Lösungen. Einen einzelnen Lüfter hat heute im Grunde jede Grafikkarte im Consumer Markt. Falls ihr aber ein eher kleines PC Gehäuse habt, welches selbst nicht mehr als einen Lüfter besitzt, solltet ihr eine Grafikkarte mit mindestens zwei Lüftern kaufen.

Falls das Geld keine so große Rolle spielt gibt es auch Lösungen mit einer Wasserkühlung. Diese gilt als besonders effektiv um die Abwärme der Rechenkerne abzuführen. Generell gilt: Je heißer die Karte, desto mehr nimmt ihre Leistungsfähigkeit ab! Eine gute Kühlung ist also gerade beim Gaming sehr wichtig.

Hersteller

Im Consumer Markt gibt es zwei nennenswerte Hersteller: NVIDIA und AMD. Effizienztechnisch hat meist NVIDIA die Nase vorn, dafür haben die AMDs öfter ein besseres Preis/Leistungs-Verhältnis. Eine Zeit lang trieb sich das hartnäckige Gerücht um, NVIDIA Karten kommen mit Intel Prozessoren besser klar als AMD Karten - das ist inzwischen aber wirklich nicht mehr als ein Gerücht. Bei der aktuellen Marktsituation gibt es sowohl für die eine als auch für die andere Marke genügend Gründe, sie zu kaufen. Pauschal besser ist keine der beiden.

Preis

Die neusten Grafikkarten von NVIDIA sind der Oberklasse, keine Frage. Der Preis nur leider ebenfalls. Für die meisten werden deshalb jetzt Grafikkarten aus der älteren Generation interessant, da diese aktuell einen spürbaren Preisverfall erleben. Für eine GTX 1080 wurde vor einem halben Jahr teilweise mehr als das Doppelte verlangt wie bei den aktuellen durchschnittlichen Preisen. Trotzdem wird die Grafikkarte die nächsten 3-5 Jahre vermutlich die meisten neuen Spiele problemlos packen (auf FullHD).

Außerdem lohnt es sich, regelmäßig nach Sonderangeboten oder Restverkäufen bei Online Händlern eurer Wahl zu suchen - Da sind manchmal wahre Schnäppchen dabei.

Mobile

Bei vielen mobilen Geräten wie Notebooks oder Smartphones gibt es keine sichtbare Grafikkarte - denn sie ist meist ein Bestandteil eines SoCs, also meist nur eine weitere Recheneinheit neben der CPU. Und obwohl auf einem Snapdragon 845 oder einem modernen Intel oder AMD Chip schon eine beachtliche Grafikleistung erzielt werden kann, so sind die Ergebnisse kaum vergleichbar mit einer Gaming-Grafikkarte. http://gpu.userbenchmark.com/ bietet dazu viele spannende Vergleiche.

Wichtige Begriffe

FPS: Um diese Abkürzung kommt man definitiv nicht herum, zumal sie gleich mehrere Bedeutungen hat. Im technischen Kontext beschreibt sie die Frames per Second, also Einzelbilder pro Sekunde. Je mehr eine Grafikkarte schafft, desto flüssiger erscheint das Bewegbild für den Menschen.

FullHD, 4k, 8k,...: Beschreiben typische Bildschirmauflösungen. Eine Bildschirmauflösung ist die Menge an Pixeln, die ein Ausgabegerät (Display) physisch darstellen kann. FullHD ist heutzutage ein sehr üblicher Standard, mit einer Menge von 1920 (Breite) mal 1080 (Höhe) Pixeln.

SoC(s): Ist die Abkürzung für "System on a Chip". Das heißt, auf dem Bauteil befindet sich mehr als nur ein Prozessor, meist alle wichtigen Komponenten um ein System (wie ein Handy) zu betreiben.

Fazit - Grafikkarten

Sie sind faszinierend, komplex und teuer - aber fast überall unverzichtbar. Dieser Artikel soll einen ersten Eindruck vermitteln, was hinter dem Gebilde aus Kunststoff, Metall und Silikon steckt und was das schlussendlich bedeutet. Außerdem ist sie aktuell die Komponente, die am schnellsten altert, denn der Fortschritt der hier von Generation zu Generation erzielt wird ist deutlich höher als zum Beispiel bei CPUs. Falls ihr das bei dem ein oder anderen Spiel auch schon zu spüren bekommen habt, ist das aber kein Grund zur Panik! Die Grafikkarte lässt sich in den meisten PCs (Nicht Notebooks!) sehr leicht erneuern. Das ist in den meisten Fällen sinnvoller, als gleich einen neuen PC zu kaufen 😉